From ransomware to botnets, malware takes seemingly endless forms, and it’s forever proliferating. Try as we might, the humans who would defend our computers from it are drowning in the onslaught, so they are turning to AI for help.

Cybersecurity firm Endgame released a large, open-source data set called EMBER (for “Endgame Malware Benchmark for Research”). EMBER is a collection of more than a million representations of benign and malicious Windows-portable executable files, a format where malware often hides. A team at the company also released AI software that can be trained on the data set. The idea is that if AI is to become a potent weapon in the fight against malware, it needs to know what to look for.

Your new post is loading...

Your new post is loading...

Minthogy a támadók kiválóan hasznosítják a gépi okosságot az újabb és újabb vírusok (miegyebek) előállításában, ideje, hogy a védelem is felvegye a tempót. Az EMBER nem az egyetlen és nem is az első ilyen próbálkozás, de mindnek lehet örülni…

Az IBM egy más területen veti be a mesterséges intelligenciát: Watson, a biztonsági szakember. Ők a vállalati rendszereket ért támadásokat akarják gyorsan felismerni. Az a cél, gyorsan, egy szempillantás alatt elemezze információk tömkelegét, és találja meg az összefüggéseket a különböző rendszerekben észlelt és nehezen összekapcsolható események között. Ha sikerül ezeket a kapcsolatokat felfedezni, akkor azonnal kiderül, hogy önmagukban ártalmatlannak tűnő események együttesen támadásra utalnak.

Az Endgame áprilisi bejelentése óta mintha nem lenne újabb hír erről az EMBER-ről, pedig tényleg jó lenne valami pozitívum!

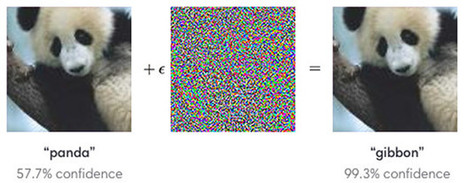

Azt mondja az MIT írásának címe, hogy épp olyan könnyedén azonosítja a rosszindulatú szoftvert, amilyen könnyen felismer egy macskát.

Halkan megjegyzem, friss egyetemi kutatások szerint, ez sem megy annyira könnyen a gépnek. Teknős vagy lőfegyver?

#MIT @MITnews #EMBER #Endgame @Endgame #IBM #Watson #imagerecognition #mesterségesintelligencia #AI #machinelearning