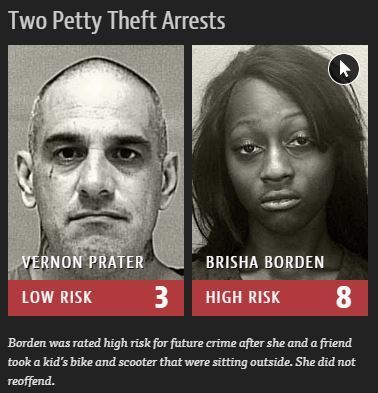

There’s software used across the country to predict future criminals. And it’s biased against blacks.

ON A SPRING AFTERNOON IN 2014, Brisha Borden was running late to pick up her god-sister from school when she spotted an unlocked kid’s blue Huffy bicycle and a silver Razor scooter. Borden and a friend grabbed the bike and scooter and tried to ride them down the street in the Fort Lauderdale suburb of Coral Springs.

Just as the 18-year-old girls were realizing they were too big for the tiny conveyances — which belonged to a 6-year-old boy — a woman came running after them saying, “That’s my kid’s stuff.” Borden and her friend immediately dropped the bike and scooter and walked away.

But it was too late — a neighbor who witnessed the heist had already called the police. Borden and her friend were arrested and charged with burglary and petty theft for the items, which were valued at a total of $80.

Your new post is loading...

Your new post is loading...

Rendszerűen elfogult “okos” gépet használnak az amerikai igazságszolgáltatásban már hosszú évek óta. A gép 1-10-ig osztályozza az elkövetőket, hogy mennyire valószínű az újabb bűncselekmény elkövetése. Ezt elég hangsúlyosan veszik figyelembe az ítélet súlyosságának meghatározásakor, sőt már korábban is, amikor eldöntik, hogy szabadlábon védekezhet-e az illető.

A gépben titkos algoritmus dolgozik, ami 137 kérdés alapján saccolja meg a jövőt. Különböző utólagos elemzések szerint 65-70%-os eséllyel találja el, hogy visszaeső lesz-e az illető.

A cikk szerzői utólag elvégezték két év és 7000 eset elemzését. Ez azt mutatta, hogy nagyon eltérően téved a gép fehérek és feketék esetében. A magas kockázatúnak minősített fehérek 23%-a nem követett el újabb bűncselekményt 2 éven belül, a feketéknek viszont 45%-a maradt tiszta. Az alacsony kockázatúnak minősített fehéreknek 48%-a esett bűnbe, a feketéknek csak 28%-a. Elég durva eltérések vannak a hibaszázalékokban!

Az okát nem könnyű megmondani, de valószínűleg itt is az történik, mint más területeken (pl.: HR). A régen meglévő előítéletek épülnek be (valószínűleg nem szándékosan) a programokba. Hogy történhet ez? A döntés múltbeli adatok, statisztikák alapján történik. Azok pedig tartalmazzák a múltbeli előítéleteket is.

Itt nem valódi mesterséges intelligenciával állunk szemben, de annak elemei megjelennek a program működésében. A mesterséges intelligenciát felelősen kutatók és használók egyre gyakrabban teszik fel a kérdést, hogy értjük-e a gép döntéseit. Új irányzat, hogy a gépnek kelljen elmagyaráznia, hogy mi vezetett a döntéséhez. Ez az “explainable” vagy “understandable” mesterséges intelligencia. Óriási előrelépés lenne, ha általánossá válna!

#legal #AI #bias #artificial_intelligence #USA #Florida #profiling